Information Technology Reference

In-Depth Information

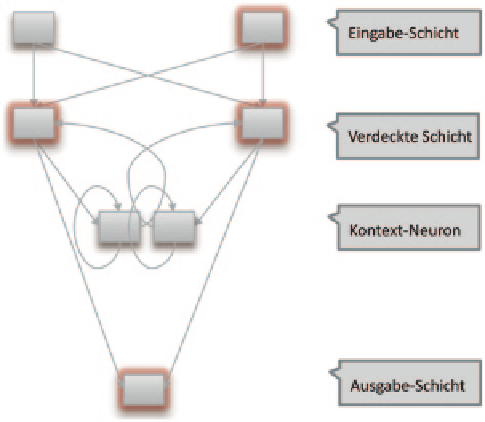

Abb. 4.15

Elman-Netz

trainierbaren Verbindungen vorwärts gerichtet, sodass zum Trainieren der Backpropaga-

tion-Lernalgorithmus angewendet werden kann. Die Kontext-Neuronen können durch-

aus zusätzliche Rückkopplungen zu sich selbst aufweisen, womit der Einfluss der älteren

Muster gesteuert werden kann. Die Stärke des Erinnerungsfaktors wird dabei durch einen

vorgegebenen, festen Faktor l gesteuert. Da die Zahl der Ausgabe-Neuronen durch das zu

lösende Problem terminiert wird, liegt damit in einem Jordan-Netze die Zahl der Kontext-

Neuronen fest. Dies kann unter Umständen zu Einschränkungen in den Rückkopplungen

führen (Abb.

4.15

).

Um hier etwas flexibler zu sein, lassen sich die Rückkopplungen anstelle von der Aus-

gabeschicht auch von der inneren Schicht aus ansteuern. Das so entstehende

Elman-Netz

benutzt dabei so viele Kontext-Neuronen, wie Neuronen in der inneren Schicht vorhanden

sind. Die Größe der inneren Schicht kann dabei leichter variiert werden, da diese nicht

direkt aus der Problemstellung heraus festgelegt ist. Dies führt letztlich dazu, dass die Zahl

der Kontext-Neuronen leichter als bei Jordan-Netzen geändert werden kann, was oftmals

dazu führt, dass sich mit Elman-Netzen bessere Resultate als mit Jordan-Netzen erzielen

lassen.

Selbstorganisierende Netze

, auch als selbstorganisierte Karten (Self-Organizing Maps)

oder nach ihrem Entwickler

Kohonen-Karten

bezeichnet, sind eine Form von Netzen, die

in der Lage sind, ein klassifizierendes Verhalten ohne vorgegebene Trainingsausgaben zu

erlernen. Motiviert wird dies durch das menschliche Vorbild, wo viele Dinge sich unter-

scheiden oder zusammenfassen lassen, ohne dass vorher explizit gesagt wurde, was richtig

ist. So ist auch der Mensch in der Lage zu klassifizieren. Solche Neuronalen Netze werden

vor allem in den Problembereichen angewendet, in denen für vorliegende Eingabedaten

keine zugehörigen, wünschenswerten Ausgabewerte exakt angegeben werden können.