Information Technology Reference

In-Depth Information

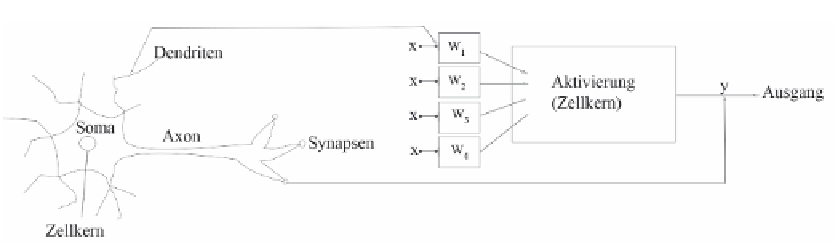

Bild 4-1

Darstellung eines natürlichen (linke Seite) und eines formalen Neurons (rechte Seite)

Wie es sich aber zeigte, waren die Funktionen des Gehirns nicht hinreichend im Modell erfasst,

da zwar die Informationsübertragung als Aktivitätsausbreitung damit gut erklärt werden kann,

jedoch nicht die Lernfähigkeit. Diese bedeutet hier vor allem, dass die Art der Aktivitätsaus-

breitung verändert werden kann, je nach zu lernendem Problem natürlich.

Entscheidend waren diesbezüglich die auf dem Philosophen und Psychologen William James

aufbauenden Arbeiten von Donald Hebb (1949), der ein allgemeines Modell der Lernprozesse

im Gehirn postulierte, das seitdem in den Grundzügen molekularbiologisch bestätigt wurde.

Hebb hat sich mit der Funktionsweise von Nervenzellen beschäftigt und stellte eine Regel auf,

die vom Grundprinzip sehr einfach ist:

“When an axon of cell A is near enough to excite a cell B and repeatedly or persistently

takes part in firing it, some growth process or metabolic change takes place in one or both

cells such that A's efficiency, as one of the cells firing B, is increased.” (Hebb 1949, 62)

Damit wurde eine der wichtigsten Lernregeln formuliert, die in unterschiedlichen Variationen

in verschiedenen NN-Modellen vorhanden ist (vgl. unter anderen Zell 2000). Etwas anschauli-

cher formuliert kann man sich diese Regel von Hebb auch so vorstellen, dass die Verbindungen

zwischen den Zellen A und B sich so verändern: Wenn ständig A auf B einwirkt, dann wird im

Verlauf des entsprechenden Lernprozesses die Wirkung von A auf B größer. Entsprechend

verringert sich eine ursprüngliche Einwirkung von A auf B oder verschwindet ganz, wenn die

Aktivierung von A aus irgendwelchen Gründen auf B keine Wirkung mehr ausübt. Noch an-

schaulicher: Wenn die Verbindung zwischen A und B über längere Zeiträume nicht genutzt

wird, stirbt diese Verbindung gewissermaßen ab - B wird praktisch vergessen.

Für die Entwicklung künstlicher NN sind noch einige zusätzliche Eigenschaften des Gehirns

von Bedeutung, die hier jedoch nur kurz angesprochen werden: Die Neuronen (Neuronen-

verbände) sind in unterschiedlichen Schichten angeordnet, die hierarchischen Prinzipien gehor-

chen können. Es gibt jeweils Verknüpfungen (Verbindungen) zwischen den einzelnen Schich-

ten, die wiederum durch bestimmte Neuronen gewährleistet sind (Dudel u. a. 2001). Auch die

Codierung der Informationen spielt eine wesentliche Rolle, die sowohl bei dem biologischen

Vorbild als auch bei den künstlichen Netzen zum Teil sehr komplex sein kann.

Da die Materie der neuronalen Netze sehr umfangreich ist, werden wir in dieser Arbeit nur

einige ausgewählte Netzwerke thematisieren und nicht alle verschiedenen Typen darstellen.

Leser/innen, die sich für weitere Details interessieren, seien auf die von uns genannte Spezialli-

teratur verwiesen. Wir konzentrieren uns hier auf die wichtigsten Grundtypen, die als repräsen-

tativ für das gesamte Feld der neuronalen Netze angesehen werden können, und vor allem auf

die Grundlogik, insoweit sie allen Typen neuronaler Netze gemeinsam ist. Zusätzlich stellen

wir ein von uns entwickeltes neues Lernparadigma dar, das insbesondere zur Konstruktion

eines neuen selbstorganisiert lernenden Netzwerks führte.

Search WWH ::

Custom Search