Information Technology Reference

In-Depth Information

1

1

1

y

1

1

1

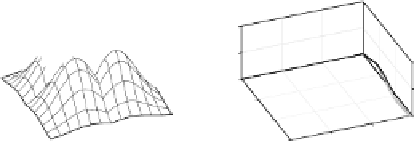

einzelne Basisfunktion

alle Basisfunktionen

Ausgabe

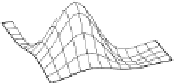

Abbildung 6.12: Radiale Basisfunktionen und Ausgabe eines Radiale-

Basisfunktionen-Netzes mit vier versteckten Neuronen für die Biimplikation.

jedoch wenig brauchbar. Erstens ist i.A. die Zahl der Trainingsbeispiele so groß, dass

man kaum für jedes ein eigenes Neuron anlegen kann: das entstehende Netz wäre

nicht mehr handhabbar. Außerdemmöchte man aus offensichtlichen Gründen, dass

mehrere Trainingsbeispiele von der gleichen radialen Basisfunktion erfasst werden.

Radiale-Basisfunktionen-Netze

(ohne den Zusatz „einfach“) haben daher weniger

Neuronen in der versteckten Schicht, als Trainingsbeispiele vorliegen. Zur Initiali-

sierung wählt man oft eine zufällige (aber hoffentlich repräsentative) Teilmenge der

Tra iningsbe i spi e l e a l s Zent ren der radia l en Bas i s funkt ionen, und zwar e in Tra inings -

beispiel für jedes versteckte Neuron (dies ist allerdings nur eine mögliche Methode

zur Bestimmung der Zentrumskoordinaten, eine andere wird weiter unten bespro-

chen). Durch die ausgewählten Beispiele werdenwieder die Gewichte von der Einga-

beschicht zur versteckten Schicht festgelegt: Die Koordinaten der Trainingsbeispiele

werden in die Gewichtsvektoren kopiert. Die Radien werden ebenfalls, wie bei ein-

fachen Radiale-Basisfunktionen-Netzen, heuristisch bestimmt, nur diesmal aus der

ausgewählten Teilmenge von Trainingsbeispielen.

Bei der Berechnung der Gewichte der Verbindungen von den versteckten Neu-

ronen zu den Ausgabeneuronen tritt nun allerdings das Problem auf, dass das zu

lösende Gleichungssystem überbestimmt ist. Denn da wir einen Teil der Trainings-

beispiele ausgewählt haben, sagen wir

k

,habenwirfürjedesAusgabeneuron

m

Glei-

chungen (eine für jedes Trainingsbeispiel), aber nur

k

+

1Unbekannte(

k

Gewichte

und einen Biaswert) mit

k

<

m

.WegendieserÜberbestimmungwählenwirdieBias-

werte der Ausgabeneuronen diesmal nicht fest zu 0, sondern behandeln sie über die

Umwandlung in ein Gewicht (vergleiche dazu Abbildung 3.18 auf Seite 26).

Formal stellen wir analog zu einfachen Radiale-Basisfunktionen-Netzen aus den

Aktivierungen der versteckten Neuronen die

m

(

k

+

1

)

Matrix

1ou

(

l

1

)

out

(

l

1

)

... out

(

l

1

)

v

1

v

2

v

k

1ou

(

l

2

)

out

(

l

2

)

... out

(

l

2

)

v

1

v

2

v

k

A

=

.

.

.

.

1ou

(

l

m

)

out

(

l

m

)

... out

(

l

m

)

v

1

v

2

v

k