Information Technology Reference

In-Depth Information

f

f

(

x

i

)

(

x

i

)

i

x

i

x

i

0

0.200

3.112

11.147

0.011

6

10.811

1

0.211

2.990

0.021

5

2

0.232

2.771

10.196

0.029

9.368

3

0.261

2.488

0.035

4

4

0.296

2.173

8.397

0.040

3

7.348

5

0.337

1.856

0.044

6

0.380

1.559

6.277

0.046

2

5.228

7

0.426

1.298

0.046

1

8

0.472

1.079

4.235

0.046

x

3.319

9

0.518

0.907

0.045

0

0

1

2

3

4

10

0.562

0.777

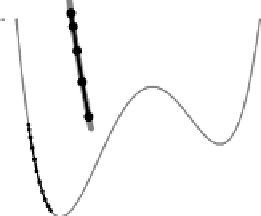

Abbildung 5.27: Gradientenabstieg mit Momentterm (

= 0.9) ausgehend vom Start-

wert 0.2 und mit Lernrate 0.001.

f

i

x

i

f

(

x

i

)

(

x

i

)

x

i

1.050

0

1.500

2.719

3.500

6

1

0.450

1.178

4.699

0.705

5

0.509

2

1.155

1.476

3.396

3

0.645

0.629

1.110

0.083

4

0.005

4

0.729

0.587

0.072

3

5

0.723

0.587

0.001

0.000

6

0.723

0.587

0.000

0.000

2

7

0.723

0.587

0.000

0.000

1

8

0.723

0.587

0.000

0.000

x

9

0.723

0.587

0.000

0.000

0

0

1

2

3

4

10

0.723

0.587

Abbildung 5.28: Gradientenabstieg mit adaptiver Lernrate (mit

0

=

0.3,

c

+

=

1.2,

c

=

0.5) ausgehend vom Startwert 1.5.

Durch eine adaptive Lernrate kann das chaotische Hin- und Herspringen, wie

wir es aus Abbildung 5.22 auf Seite 68 ablesen können, vermieden werden. Dies

zeigt Abbildung 5.28, das den Lernvorgang ausgehend von der im Vergleich zu Ab-

bildung 5.22 sogar noch größeren Lernrate

= 0.3 zeigt. Zwar ist dieser Anfangs-

wert zu groß, doch wird er sehr schnell durch den Verkleinerungsfaktor korrigiert,

so dass in erstaunlich wenigen Schritten das Minimum der Funktion erreicht wird.

Für eine Veranschaulichung der Fehlerrückpropagationmit Momentterm verwei-

sen wir wieder auf die schon auf Seite 68 erwähnten Programme

wmlp

und

xmlp

.

Diese Programme bieten die Möglichkeit, einen Momentterm zu verwenden, wo-

durch auch hier das Training deutlich beschleunigt wird.

We i t e r we i s en wi r auf d i e Kommandoze i l enprogr amme h i n , d i e unt e r

http://www.computational-intelligence.eu